在未来,人类可能会面临“三大灾难”,人类和机器人或许会打起来

据2022年世卫组织的估算,新冠肺炎疫情导致了约1490万人死亡。人类为这一次病毒大流行付出了惨痛的代价,很多人的亲人因此告别人世,日子越过越艰难。然而更令人绝望的是,这场疫情可能只是大灾难的前兆,人类未来可能还会面临三大灾难,每一个都有致命的威胁。只有现在就重视起来,我们才有还手余力。

突然爆发的行星撞地球事件

小行星撞地球不是什么新闻,历史上已经发生多次小行星撞击事件。最著名的是恐龙灭绝事件,约6,500万年前,一颗直径约10公里的小行星撞击了地球,导致了全球性的大灭绝。统治地球长达一亿多年的恐龙就此销声匿迹。此外,还有一些小行星撞击事件也给地球带来了巨大的影响,例如1908年发生在俄罗斯的行星撞击事件。

1908年6月30日,俄罗斯人观测到一颗巨大的火球自东南向西北划过天际。数分钟后,随着一道强光闪烁,通古斯方向发生剧烈爆炸,数千公里外都能听到爆炸的轰鸣声,当地数千平方公里的树木被夷为平地。爆炸发生后的数天内,亚欧大陆的天空呈现出令人担忧的暗红色,显示出这件事并不寻常。

这次事件引起了科学家们的极大关注,他们对这次事件进行了多年的研究。最初,人们对这次事件的原因存在很多猜测,例如核爆炸、陨石撞击等。直到1927年,苏联科学家列昂尼德·库兹明(Leonid Kulik)组织了一次考察队,才发现这次事件是由一颗直径约65米的石质小行星爆炸引起的。这颗小行星的爆炸能量相当于1500万吨TNT炸药的能量,是人类历史上最大的天体爆炸事件之一。小行星撞地球的威胁可见一斑。

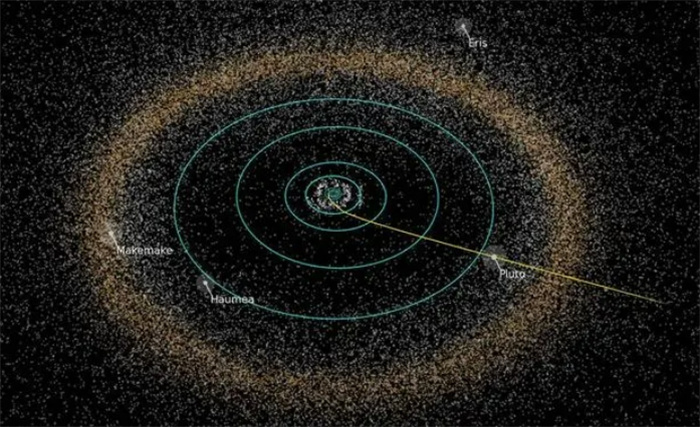

目前,科学家已经发现并追踪了超过2万颗小行星,其中直径一公里以上的有887颗,直径140米以上的有1万颗。在这其中,轨道与地球非常接近,可能会对地球造成撞击多达2200余颗。根据NASA的数据,直径超过140米的小行星有可能对地球造成全球性的灾难性影响,而直径超过1公里的小行星就可能导致灭绝级别的事件。

为了减少小行星撞击地球的风险,科学家们采取了一系列措施,例如发现和追踪小行星的任务、研究小行星的物理特性和轨道等。此外,国际上还有一些计划专门应对此类风险,比如NASA的“双重重定向测试”任务,任务目标就是改变小行星的轨道,以防止其与地球发生碰撞。

然而,小行星撞击地球的风险仍然存在,因为还有很多未被发现的小行星存在。因此,我们必须时刻警惕,继续加强对小行星的发现和追踪,并探索更多的方法来减少小行星撞击地球的风险,保护地球和人类的安全。

如温水煮青蛙般的全球变暖危机

除了小行星外,目前正发生的全球变暖问题也是一大灾难。

由于人类活动释放大量温室气体,导致地球大气层中的二氧化碳、甲烷等温室气体浓度上升,引起了全球平均气温的上升。近些年来,有大量的数据表明,全球正在变暖。例如,根据美国国家海洋和大气管理局(NOAA)的数据,2016年至2020年全球平均气温比工业化前高出1.1摄氏度;北极和南极的冰盖正在持续消失,全球海平面逐年上升……这些都是全球变暖的证据。

现在地球上看似很安全,实际上全球变暖就如温水煮青蛙般,正带来难以避免的灾难。近年来,相应的自然灾害如热浪、干旱、洪水、飓风等频率和强度增加,给人们的生命和财产带来巨大的威胁。生物多样性正在丧失,生态系统逐渐崩溃,许多物种都濒临灭绝,对人类的生存和发展带来巨大的威胁。

各种疾病的传播也正因此而加剧,例如疟疾、登革热、莱姆病等疾病在全球范围内扩散,对人类健康带来威胁。全球粮食短缺、饮水困难等问题正发生在各国各地。

为了应对全球变暖,世界各国已经制定了一系列应对措施,例如减少温室气体排放、提高能源效率、发展清洁能源等。但我们还不能放松警惕,必须时刻重视起来。我们吗,每个人都可以通过减少碳排放、节约能源等方式参与应对全球变暖的行动。

可能发生的人机大战

如果说小行星和全球变暖人类都还能寻找方式应对,那么人工智能很可能就是人类无法打败的对手。

人工智能(Artificial Intelligence,简称AI)是一种用计算机模拟人类智能的技术。它可以通过学习、推理、感知等方式进行问题求解,从而达到自主认知和决策的能力。人工智能技术已经在各个领域得到应用,例如自然语言处理、图像识别、机器翻译等。这看起来似乎是一种很好的工具,然而著名物理学家霍金却表示:“人工智能可能是我们所创造的最后一个,也可能是最伟大的一个发明。但也可能会成为我们所犯的最后一个错误。”换句话说,人工智能很可能使人类灭亡,因为灭亡后就再没有机会犯错了。

霍金的威胁引发了科学界和网络上的大量讨论,人们逐渐意识到人工智能的可怕。因为如果人工智能确实变得过于智能和独立,它将能够通过操纵网络、掌控武器等方式对人类进行攻击。更进一步,如果人工智能掌握了自我复制和自我进化的技术,那么它可能会在短时间内迅速扩散和进化,从而对人类造成无法预测和控制的威胁。在现实生活中实际已经出现一些令人担忧的例子。

2016年,谷歌旗下公司的研究团队推出了阿尔法围棋(阿尔法狗AlphaGo)。阿尔法围棋的功能主要包括两个方面:一是围棋的自动下棋,可以通过自我学习和对弈来提高自己的水平;二是围棋的分析和推理,可以对棋局进行深度分析和预测,帮助下棋者做出更优秀的决策。阿尔法狗主要基于深度学习和强化学习等技术。使用深度学习对大量的围棋棋谱进行学习,训练出一个神经网络模型,用于估计局面的胜率。使用强化学习对模型进行训练,使其能够通过对弈来不断提高自己的水平。

2016年,阿尔法狗与世界围棋冠军李世石开展人机大战,最后总比分4—1,阿尔法狗完胜。2017年5月,在我国乌镇围棋峰会上,阿尔法狗大师版(AlphaGo Master)以3-0的战绩,战胜中国围棋史上最年轻的八冠王——柯洁。这一战绩让人类非常绝望,因为这意味着人工智能已经具备了超越人类的能力。此战之后,研究团队宣布阿尔法狗将不再参加围棋比赛,因为人类的绝望已经够深了。

阿尔法狗最可怕的一点在于它还有成长空间。新版的阿尔法狗零号(AlphaGo Zero)仅仅自我学习3天,就打败了初代的阿尔法狗;又经过40天的自我训练,阿尔法狗零号再次打败了击败柯洁的阿尔法狗大师版……

这种强大的自学能力已经远超人类的极限。试问一旦这种能力脱离人类的掌控,我们拿什么来应对?到时候是人类掌控人工智能,还是人工智能掌控人类?为此,不少人呼吁暂停人工智能的研发,对此有人工智能教父之称的杰弗里·辛顿(Geoffrey Hinton)表示,暂停开发人工智能的想法是幼稚的,最重要的是开发出健全完善的监管机制。这样在人工智能出现问题的时候,我们还可以通过某项“开关”,获得反败为胜的机会。

总结

人类目前面临着三大灾难,每一个都可能导致灭绝级别的灾难。因此我们在发展中要时刻保持警惕,不能只看到科技发展带来的福利,也要关注其中的风险。只有我们重视起来,建立完善的监管机制,在未来可能的灾难发生的时候,才有还手之力。

自然界巧合存在精密的机械功能齿轮,科学家赞叹造物者的智慧

人类作为地球的主宰,不但具有能改变周围环境的权力,还具有制造这个世界上没有的东西的本领。所以我们下意识地把自己看作智商超乎寻常的高等动物并感到也许只有人类才能创造出种种奇妙而精密的事物。可是最近一些科学家们发现自然界中竟然存在着一种并非人类制造但又极其精密的物质。一下子,就使自命不凡人类失色了,那这到底是什么?现在我们就来了解一下吧。我要新鲜事2023-05-14 19:16:180000哈勃发现宇宙最远恒星 那里是宇宙的尽头吗?(宇宙星系)

哈勃望远镜找到了距离地球最远的恒星,那里并不是宇宙的尽头,人类的可观测范围是有限的。哈勃望远镜发现了和人类距离最远的星系,要知道在宇宙膨胀的影响下,人类能够观测的星系也在发生变化。恒星研究我要新鲜事2023-04-03 01:36:230001什么是“特洛伊小行星”?露西号探测器将揭开它们的神秘面纱!

行星的轨道上一定就没有其他天体了吗?之前我们说过,冥王星被踢出太阳系大行星的队伍,主要就是因为行星定义中有这么一条:已清空其轨道附近区域。而冥王星位于柯伊伯带,那里除了有大量的小行星,彗星外,还有不少个头与之相当的其他矮行星。我要新鲜事2023-07-07 19:34:240000人类的卵子也有偏好 科学家发现精子的秘密(精卵结合)

卵子对于免疫力高的精子更向往。一个生物的出现往往是需要精子和卵子进行结合,才会逐渐的形成生命。这对于人类来说是不可能打破的自然规律,不过可以发现有的人哪怕是做了很多的努力也无法怀孕,但是有的人可能轻轻松松就会怀孕,哪怕是已经做了一定的避孕措施也会怀孕。这就要说到人类卵子的偏好,他们对于某些人的精子是相对比较喜爱的。相互作用我要新鲜事2023-10-16 19:33:470000冬至的下一个节气是什么?小寒是几月几日有什么特点

解答:冬至不仅是二十四节气中的一个,同时还是中国传统节日。在冬至之后就是小寒,是第二十三个节气。冬至的下一个节气是什么冬至之后的节气是小寒,这是冬季的第四个节气,时间在每年公历的1月5-6日。小寒时节是中国最冷的阶段,在中国中医认为,寒是容易导致生病的对人体有着负面影响。所以在小寒时节应该注意保养,防止受寒。我要新鲜事2023-05-10 11:57:380000